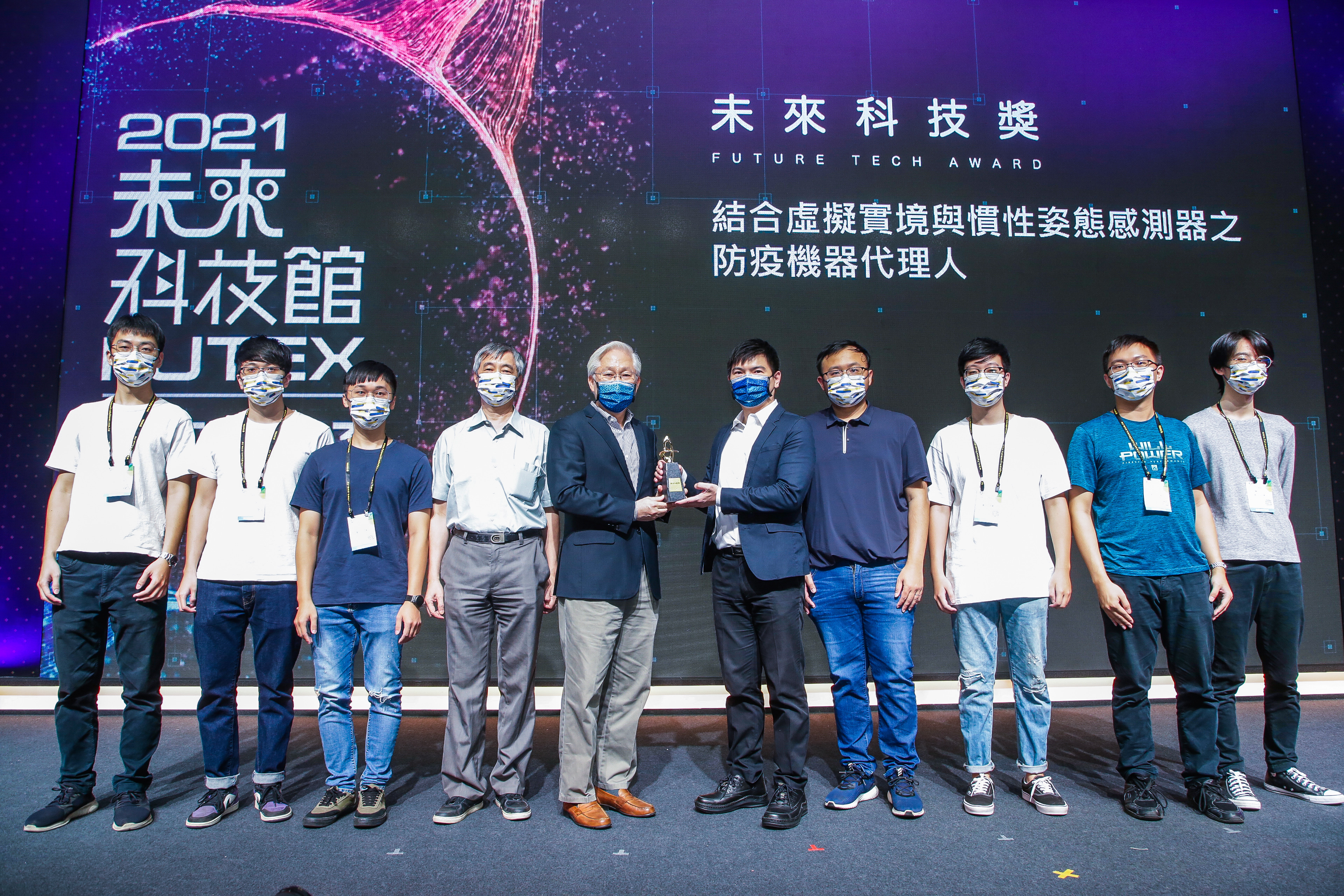

結合虛擬實境與慣性姿態感測器之防疫機器代理人

此作品2021未來科技獎競賽獲獎

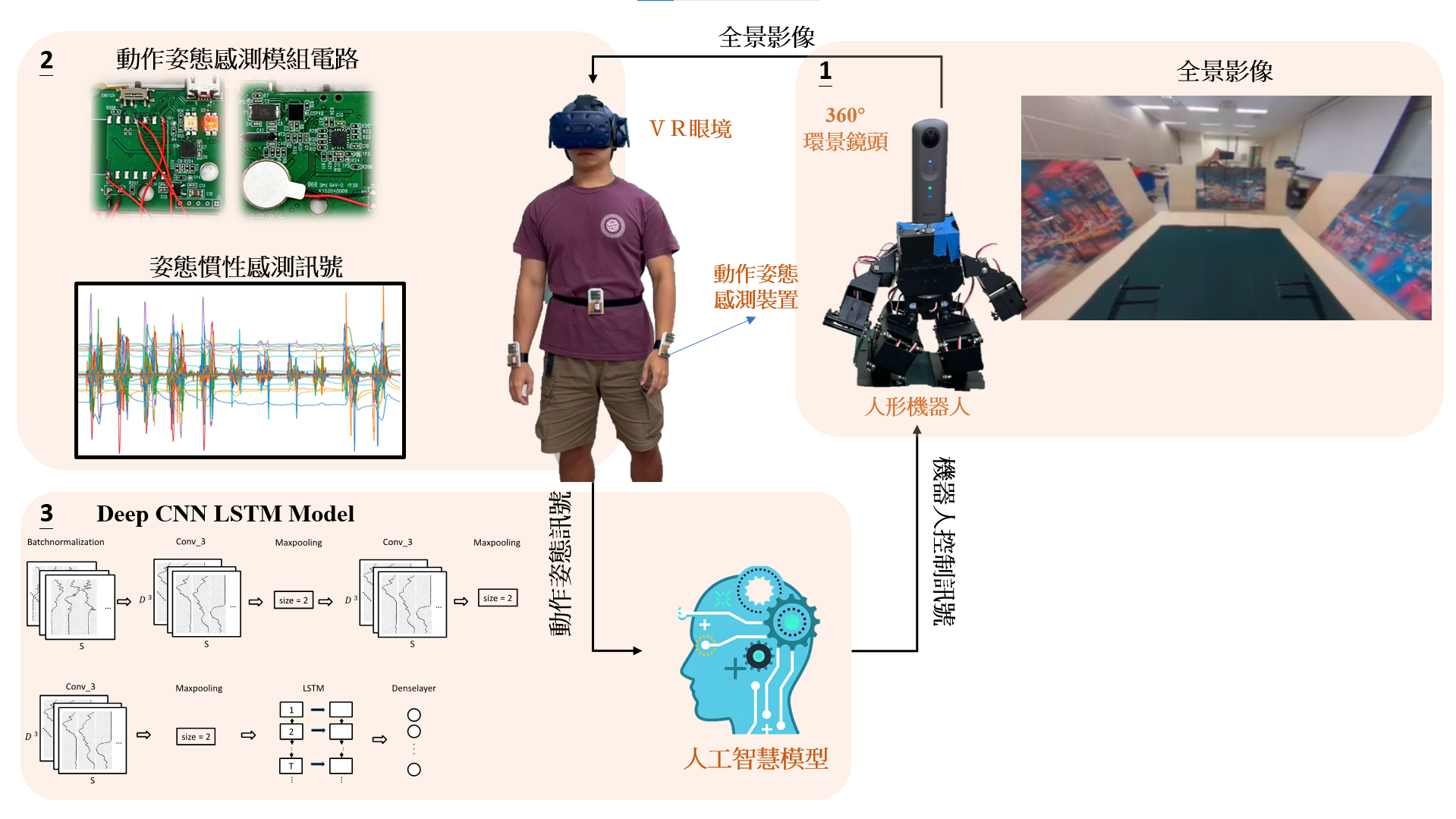

系統簡介

使用者將會透過VR眼鏡看到機器人360環景影像,接著使用者姿態動作改變時,其姿態動作感測訊號將透過WIFI送至雲端進行深度學習模型辨識。當模型辨識到使用者之動作時,將驅動機器人進行相同的動作。

系統架構

- 受試者穿戴VR裝置,並安裝360鏡頭於機器人身上,使受試者與機器人有相同的視野,能夠顯得更加臨場感。

- 姿態感測器組成一套人體姿態量測系統,利用演算法進行角度融合運算,透過Wi-Fi將資料傳輸到電腦端進行所有感測器的整合與姿態計算。

- 以CNN+LSTM模型訓練九軸資料,並於測試端進行即時動作識別,再將所判斷的動作指令透過藍芽傳輸與機器人作溝通,命令機器人作出相對應的動作。

使用設備

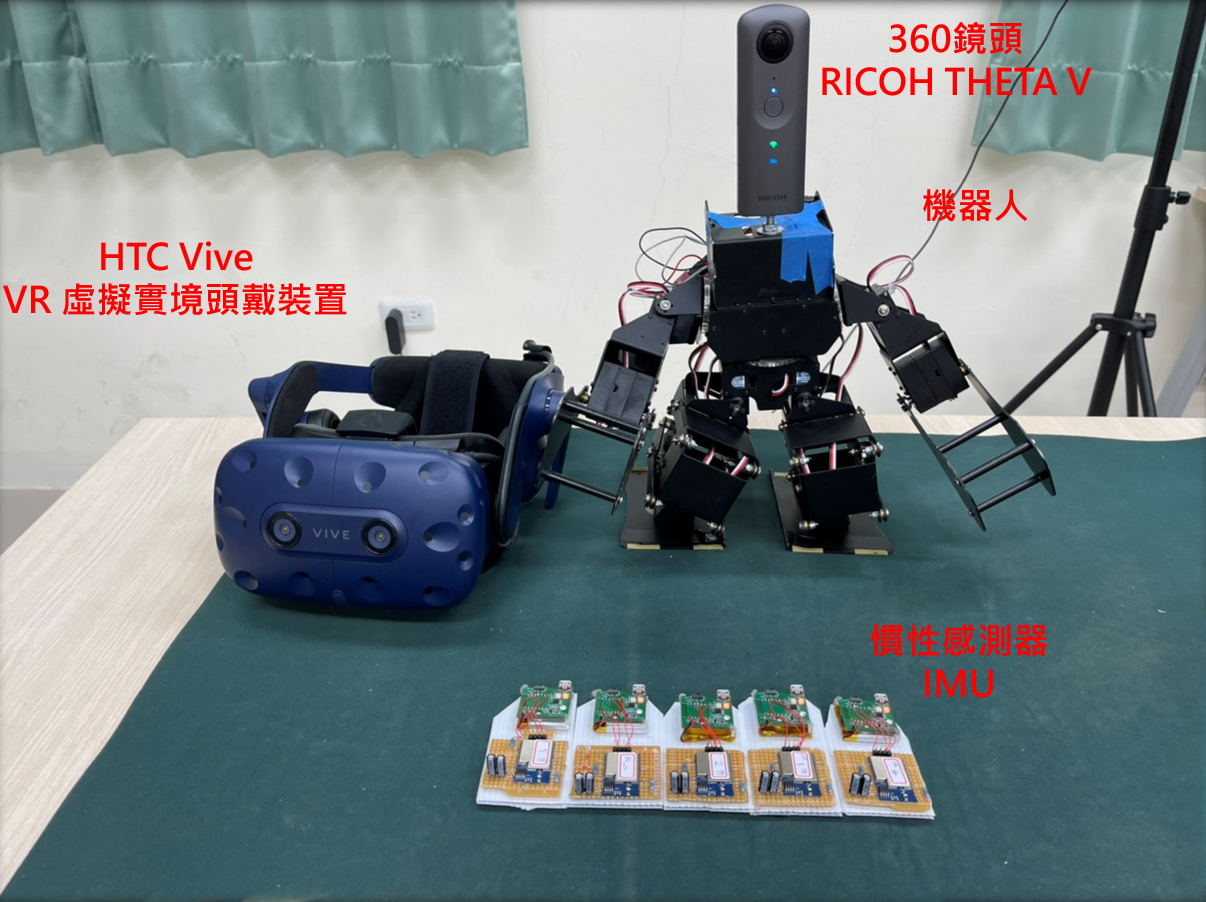

設備總覽

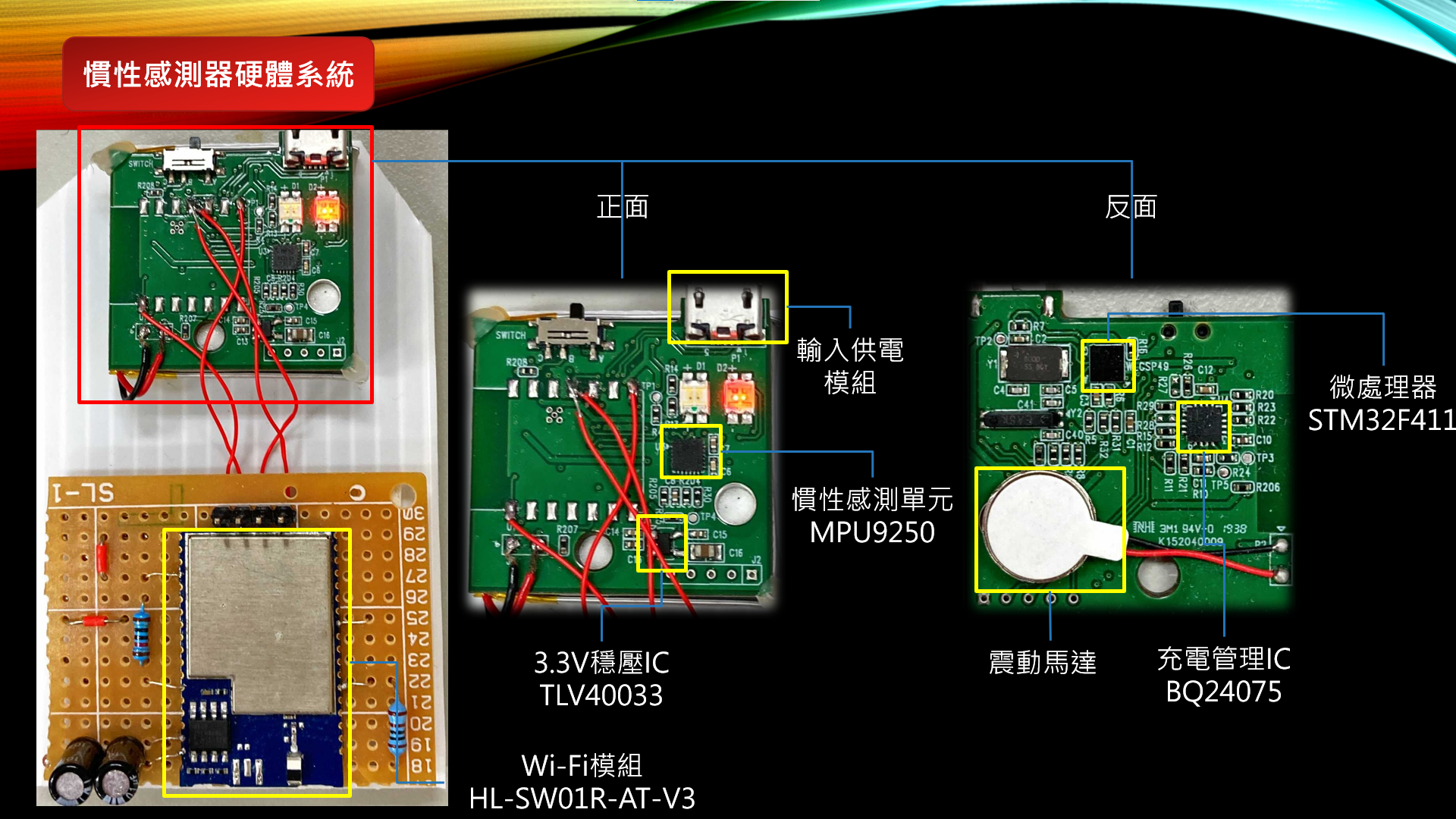

慣性感測器模組

自行開發的慣性感測器,慣性感測單元具有九軸加速規的高感度設計,內含三軸陀螺儀、加速度計及磁力計,角度探測精度可以小於0.1度。

Wifi傳輸模組,可以輕鬆地將串列設備連接至網路,透過UART與微控制器溝通。微處理器用來控制周遭的電路。

VR&360相機

360相機為theta v,擁有360度全景直播功能,透過直播網路串流將影像投射到Unity球體上,再將VR視角置於球體正中心,戴上VR眼鏡後,即可如身歷其境般看到機器人的360視角

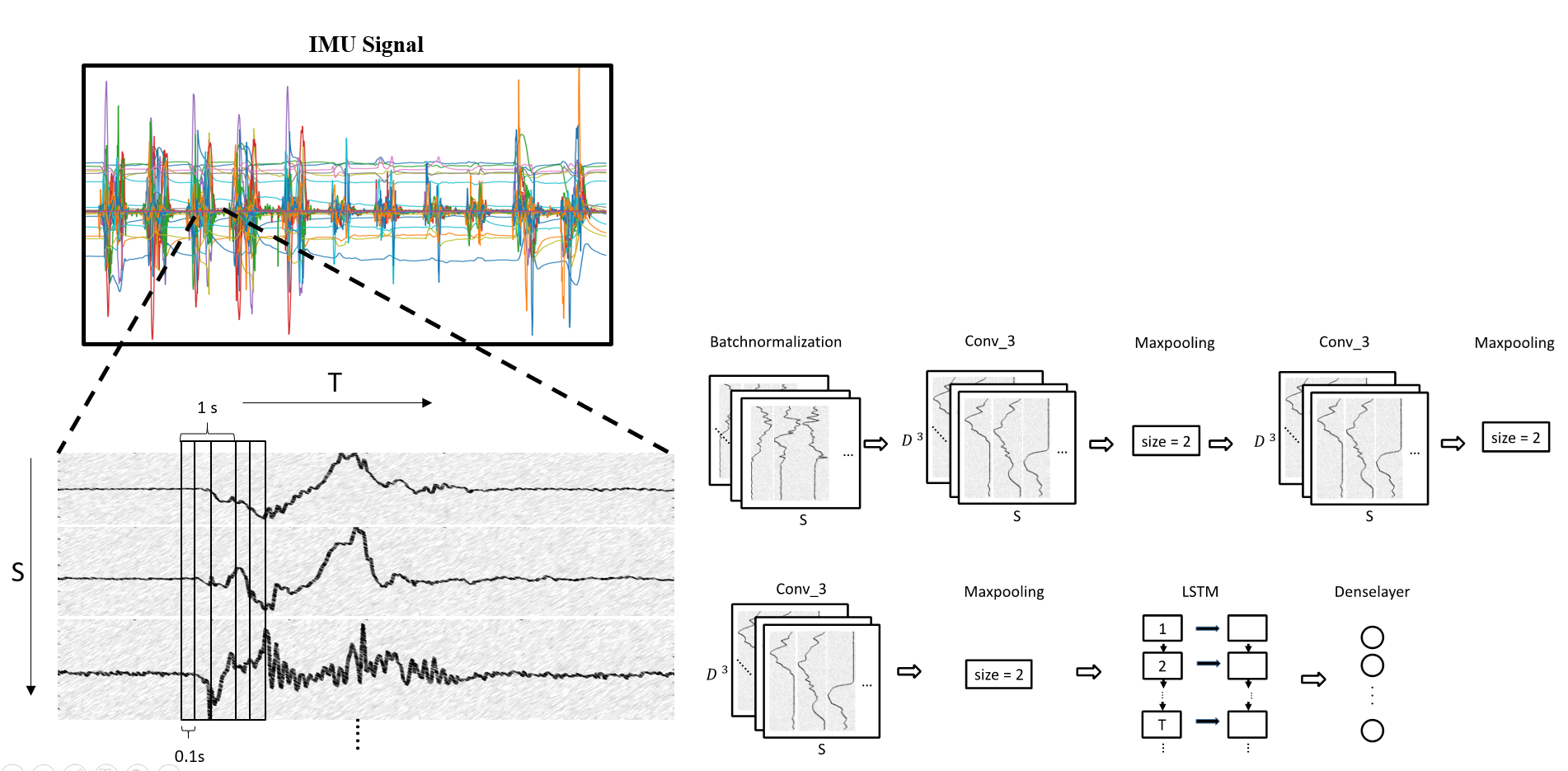

模型架構

因考慮到機器人控制之即時性,姿態感測訊號訓練資料時間範圍為動作開始時間點後0.1秒,訓練Deep Conv-LSTM 模型,進行動作姿態辨識。

受試者皆可以有效完成六種指定之動作,包括左手抬起、右手抬起、雙手抬起、前進、左轉以及右轉之動作,並且可在各種環境下皆可進行使用,不易受到外界雜訊干擾。

動作識別

使用者執行動作時,姿態慣性感測訊號送至深度學習模型進行判別,並根據其判別結果,送出動作指令給機器人,使機器人做出相對應之動作。

實體展示

於台北世貿實體展示,並開放觀眾參觀與詢問問題。

向高中學生展示與介紹我們的系統,開放參觀者親自體驗我們的系統

此作品榮獲未來科技獎

完整競賽影片 : 未來科技獎 (於影片後段有demo影片)